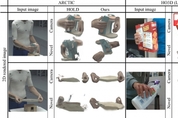

로봇 AR·VR에 ‘손맛’ 구현한다...UNIST, 단일 영상 3D 복원 AI ‘BIGS’ 개발

단일 RGB 영상만으로 양손·물체 간 3D 상호작용 실시간 복원 손이 가려지거나 보이지 않는 물체 부분까지 자연스럽게 추정 가능해 가상현실(VR), 증강현실(AR), 로봇 제어, 원격 수술 등 분야서 각광 울산과학기술원(UNIST) 백승렬 교수팀이 사람의 양손이 처음 보는 물체를 조작하는 모든 과정을 단 한 대의 카메라 영상만으로 구현하는 인공지능(AI) 기술을 개발했다. 이 기술은 가상현실(VR), 증강현실(AR), 로봇 제어, 원격 수술 시뮬레이션 등 다양한 분야에 적용될 것으로 기대받는다. 교수팀이 개발한 이번 기술은 단일 RGB 영상만으로 양손과 처음 보는 기구의 복잡한 상호작용을 실시간 3차원(3D)로 시각화할 수 있는 AI 모델 ‘BIGS(Bimanual Interaction 3D Gaussian Splatting)’다. 이는 두 손으로 낯선 물체를 조작하는 장면을 3D로 복원하거나, 양손과 의료기구가 뒤엉킨 모의 수술 장면을 AR 화면에 재현하는 기술이다. 지금까지 AI는 카메라로 촬영된 2차원(2D) 데이터만 입력받기 때문에, 손과 물체의 실제 위치나 입체적인 형태를 파악하려면 이를 3차원으로 재복원하는 과정을 거쳐야 했다. 이러한 기존 기술은