[첨단 헬로티]

SONY DEPTHSENSE 기술로 더욱 강화된 3D 측정

3차원(3D) 이미징은 산업용 픽 앤 플레이스(Pick & Place)기기(물건을 집어서 다른 곳에 옮겨 놓는 기기), 파렛트의 여러 작업과 해체(depalletization), 창고, 로봇 및 계측 애플리케이션에서 무인기, 안전 및 보안 및 환자 모니터링 애플리케이션과 같은 소비자 기반의 제품에 이르기까지 다양한 산업 분야에서 사용되고 있다.

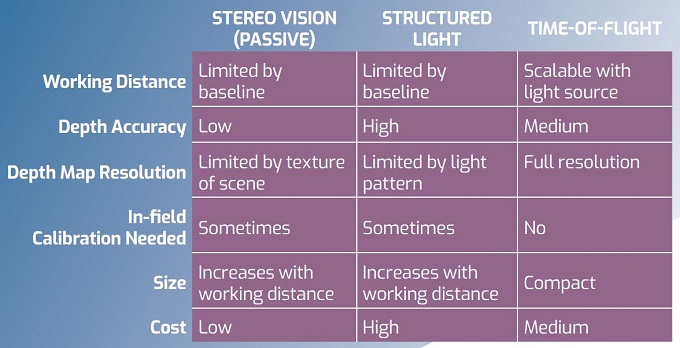

어떠한 하나의 3D 기술이 이렇게 다양한 응용프로그램에서 모두 사용될 수 없기 때문에 응용프로그램(표 1)에 어떠한 각3D 기능이 적합한지 비교해야 한다. 3D 이미징 시스템은 수동 시스템과 능동 시스템으로 구분한다. 수동 시스템은 물체에 빛을 주기 위해 주변광 또는 넓은 고정광을 사용한다.

이와 대조적으로, 능동시스템은 레이저 라인 스캐닝, 스페클 투사 (speckle projection), 프린지 패턴 투사 또는 비행거리측정센서(ToF)등과 같은 광을 공간적으로 또는 시간적으로 변조하는 다양한 방법을 사용한다. 수동 및 능동3D 이미징 시스템은 모두 빛을 비춘 피사체에서 반사된 빛을 CMOS 기반 카메라로 캡처하여 구조물의 깊이를 맵(Map)으로 생성한 다음, 필요한 경우, 물체의 3D 모델을 생성한다.

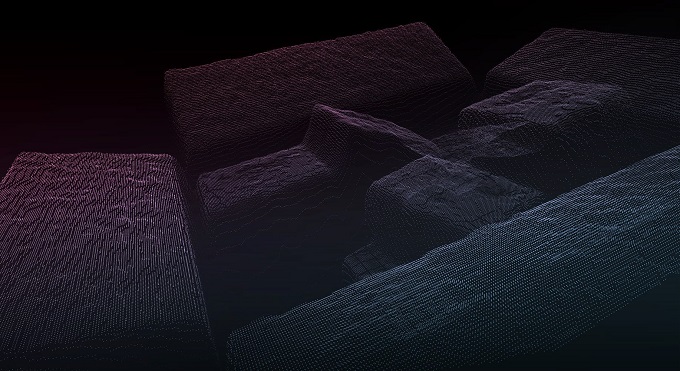

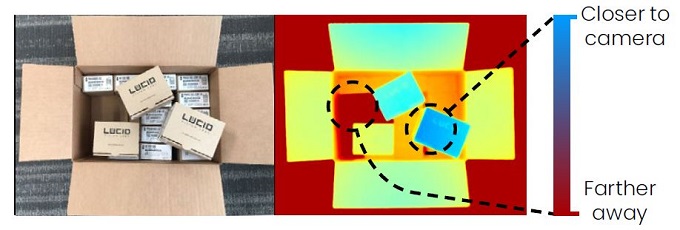

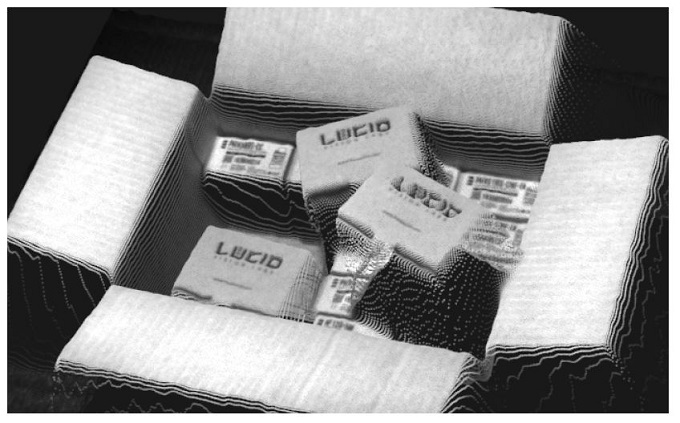

3D 이미징 시스템에서 캡처된 데이터는 수평(x), 수직 (y) 및 거리 정보(그림 1)가 포함된 포인트 클라우드(point cloud: 군)을 x, y 및 z 좌표로 표시된다. 이것은 3D 포인트들이 모인 곳이다.

그림 1. 애플리케이션에 따라 여러 3D 기술 중에 특정한 한 기술이 다른 기술에 비해 유리한 것이 있다.

이 포인트들은3D 이미징 기기(그림 1)와 물체와의 거리를 여러 색상으로 표시하는 2D 의사 색상(pseudo-color) 깊이 맵으로서 표현된다. 예를 들어 VGA 센서를 사용하여 이미지를 캡처하면 스캔방법에 따라 최대 640x480 픽셀의 깊이 맵을 생성할 수 있다. 각 픽셀의 거리정확도는 3D 측정의 정확도를 나타내는 신뢰도에 의해 결정된다. *참고: 의사 색상(pseudo-color)

단일 영상의 값들을 주어진 값의 범위로 나누어 다른 색으로 표시하는 것을 말한다. 예를 들면, 영상에서 낮은 온도는 푸른색으로 표현된다. 높은 온도는 붉은색으로 표현된다.

표 1. 애플리케이션에 따라 여러 3D 기술 중에 특정한 한 기술이 다른 기술에 비해 유리한 것이 있다.

수동 스테레오

표준 수동스테레오 비전시스템은 두 대의 카메라를 일정거리를 두고 배치하여 서로 다른 두 위치에서 장면을 캡처한다.

삼각측량법을 사용하여 두 이미지의 특징을 일치시켜 깊이 정보를 추출한다. 물체가 가까울수록 두 이미지에 나타난 물체의 특징은 측면으로 더 이동한다. 이 이동의 크기 (차이라고 함)는 일치시킨 특징의 거리를 계산하는 데 사용된다.

단일 카메라를 사용하여 3D 삼각측량 기반 시스템을 구현할 수 있다. 고정 스테레오 카메라를 쌍을 사용하는 대신, 종종 로봇에 단일 카메라를 장착하여 물체 주변의 여러 위치에 카메라를 배치한다. 특징 추출 알고리즘을 사용하여 여러 이미지를 매핑(Mapping)하면 특수 보정기법을 사용하여 3D 이미지를 재 생성할 수 있다. 시스템 정확도는 로봇의 위치 정확도에 따라서 제한된다.

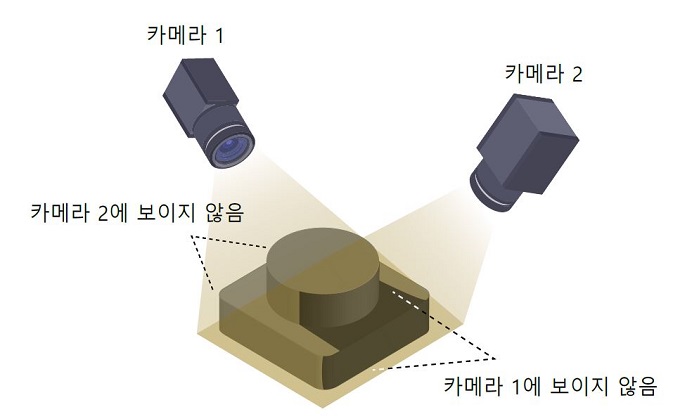

수동 3D 시스템은 물체 또는 하나의 물체 또는 여러 물체의 한 부분이 하나의 카메라에 모두 다 담기지 않을 때 오클루전(occlusion)이 발생한다. 이 경우 캡처된 이미지의 특징을 일치시킬 수 없으며 깊이를 계산할 수 없다.

그러나 스테레오 기반의 3D 시스템에서 깊이 정보를 결정할 때 잠재적인 문제를 일으킬 가능성은 오클루전(occlusion) 뿐만 아니다. 2 개 이상의 카메라를 사용하여 거의 흰색 벽처럼 특징이 거의 없거나 희미한 경우와 같은 오클루젼(occlusion) 효과가 나타나면, 두 이미지간에 일치하는 쌍을 찾을 수 없다. 각 이미지에서 일치하는 특징이 없으면 깊이 정보를 계산할 수 없다.

그림 2. 하나의 카메라로 물체의 한 부분을 이미지화하지 못할 때 오클루젼(Occlusion)이 발생한다.

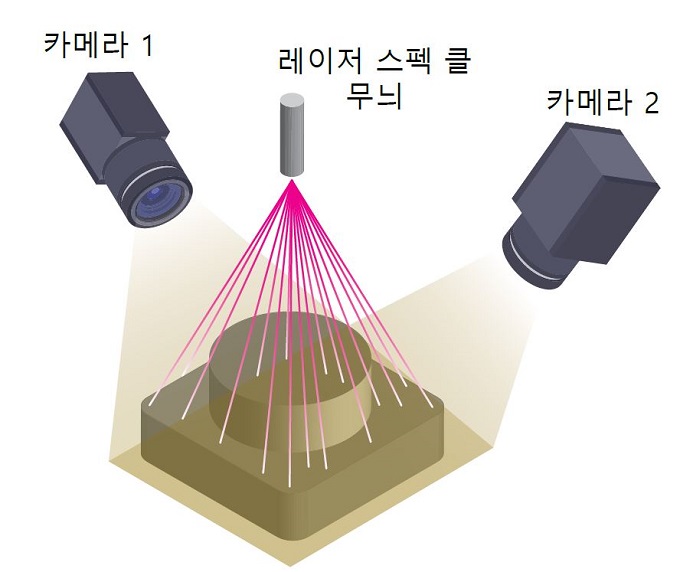

그림 3. 레이저 스페클 패턴을 사용하여 물체에 질감을(texture) 생성하는 능동 스테레오의 예

구조화된 광원

특징이 거의 없는 물체에서 특징을 찾는 문제를 해결하기 위해, 구조화된 광시스템은 물체에 패턴화 된 빛을 투사한다. 특징을 찾기 어렵거나 심지어 특징이 존재하지 않을 수도 있는 물체의 특징을 찾는 대신 광 프로젝터로 잘 정의된 빛의 패턴을 생성하며 카메라는 이것의 위치를 찾는다. 구조화된 광시스템은 일반적으로 능동 스테레오 시스템 또는 보정(calibrated) 프로젝터 시스템의 두 가지 범주로 나뉜다.

능동 스테레오 시스템은 수동 스테레오 시스템과 매우 유사한 방식으로 작동하지만 물체에 인공질감(texture)을 투사한다는 점에서 차이가 있다. 투사된 질감은(texture) LED 백라이트가 있는 기존의 레티클 프로젝터 (reticle projector, 십자망선), 회절 광학 패턴이 있는 레이저 또는 디퓨저에서 생성된 레이저 스페클(laser speckle) (그림 3)과 같은 다양한 방법으로 생성할 수 있다. 투사된 패턴은 스테레오 카메라 시스템으로 캡처하고 수동 스테레오와 동일한 방식으로 디지털 이미지 상관 관계를 통해 특징점을 매칭(feature matching)을 한다. 측정 정확도는 투사된 패턴의 해상도뿐만 아니라 스테레오 카메라의 고유 정확도에 의해 제한된다.

여기에서 설명하는 구조화된 광 시스템의 두 번째 범주는 보정된 투사된 패턴을 사용한다. 스테레오 상관 관계를 위해 질감(texture)을 투사하는 대신 보정된 프로젝터의 패턴을 정확하게 알고 3D측정의 필수 부분을 형성한다. 프로젝터가 삼각형에 알려진 정점을 형성하기 때문에 삼각측량에서 깊이를 계산하는데 단하나의 카메라만 필요로 한다. 이는 스테레오 카메라쌍의 두 번째 카메라 기능과 유사하다. 이 시스템 중에서 가장 간단한 것은 물체 표면에 레이저 광선을 투사하는 레이저 라인 스캐너이다(그림 4).

그림 4. 레이저 라인스캐너의 예. 깊이 데이터는 카메라에서 본 레이저 선 왜곡의 양으로 계산한다.

레이저에서 축의 위치에서 벗어난 위치에 있는 카메라에는 반사된 레이저 선이 표면과의 거리에 따라 왜곡되어 나타난다.

물체를 스캔하려면 레이저 선을 물체 위로 전체적으로 이동시켜 일련의 이미지를 캡처해야 한다. 이러한 반사된 레이저 선의 영상을 분석함으로써 물체의 표면 형상을 기하학적으로 재구성할 수 있다. 시스템 통합장치(Systems integrator)는 이미지를 얻고자 하는 부분의 특성에 따라 다른 방식으로 구성할 수 있는 개별 카메라와 레이저를 사용하여 시스템을 구축할 수 있다.

수동 스테레오 및 구조 광 시스템은 의미있는 결과를 내기 위해 보정을 필요로 한다. 많은 제조업체들이 광원과 카메라를 단일 장치에 탑재시켜 사전 보정으로 구조화된 광시스템을 도입했다. 이러한 시스템의 예로는 얼굴 인식과 같은 응용 프로그램을 위한 사전 보정한 저가의 구조화된 광 솔루션인 인텔 릴센스(Intel RealSense)가 있다. 개발업체들은 이러한 방식으로 비용 효율적으로 이러한 시스템을 구현할 수 있다. 산업부문에서, 하나 이상의 카메라를 장착한 구조화 광은 일반적으로 수동 스테레오 비전 시스템보다 정확성이 훨씬 높기 때문에 하이엔드(고급) 계측 애플리케이션에 사용된다.

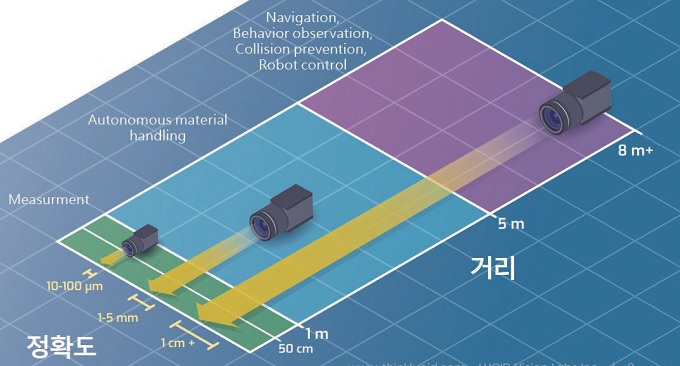

그림 6. 애플리케이션에 따라 요한 작동거리가 다를 수 있다. ToF 기술은 3m 이하의 거리에 가장 적합하다.

비행거리측정센서

짧은 작업거리에서 레이저스캐너를 사용하여 10μm보다 더 나은 우수한 표면 높이 해상도를 달성할 수 있지만 다른 애플리케이션에서는 더 긴 거리를 위한 성능을 필요로 한다. 예를 들어 네비게이션, 사람 모니터링, 장애물회피 및 모바일 로봇과 같은 애플리케이션은 수미터에 달하는 작동거리를 필요로 한다(그림 6). 이러한 애플리케이션에서는 물체가 있는지 감지하고 위치를 수센티미터 이내로 측정할 수 있어야 한다.

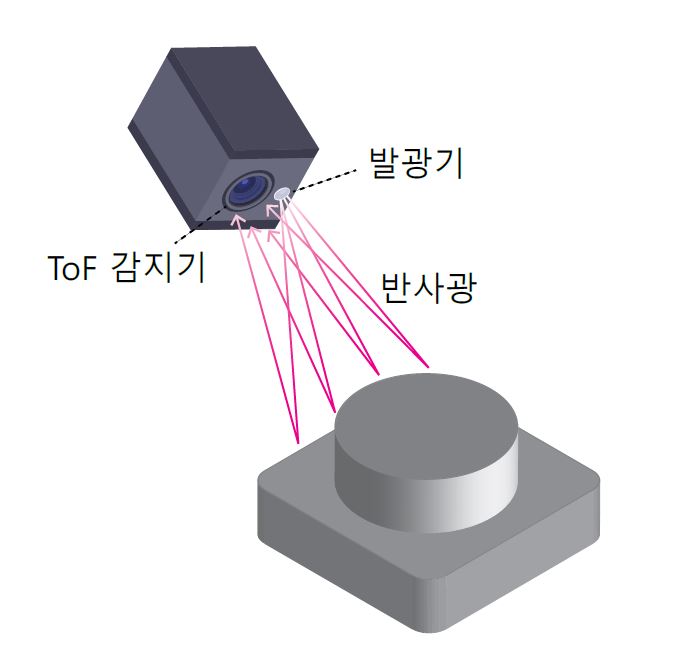

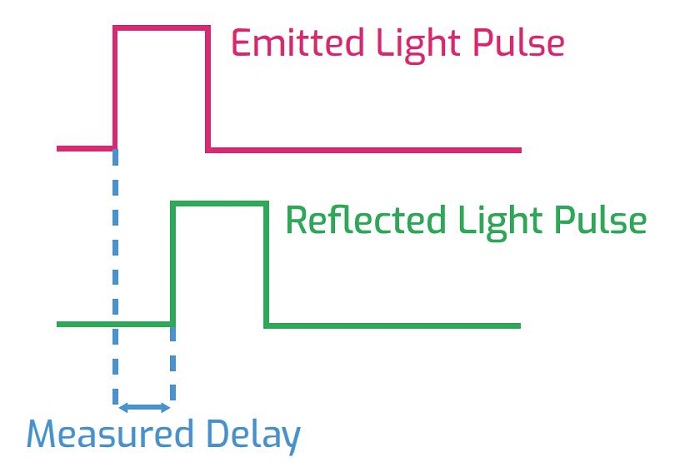

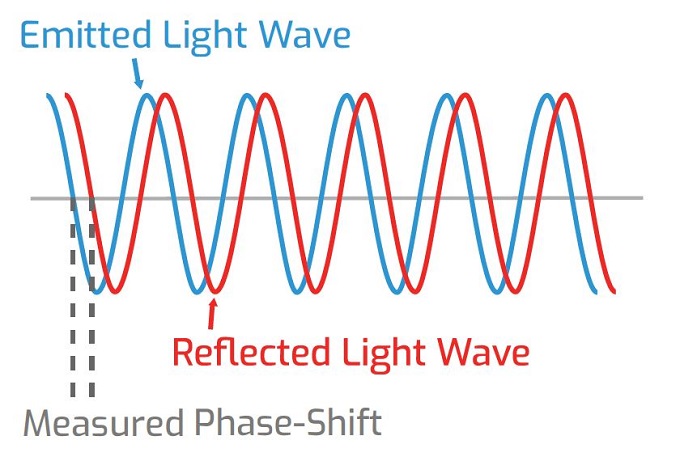

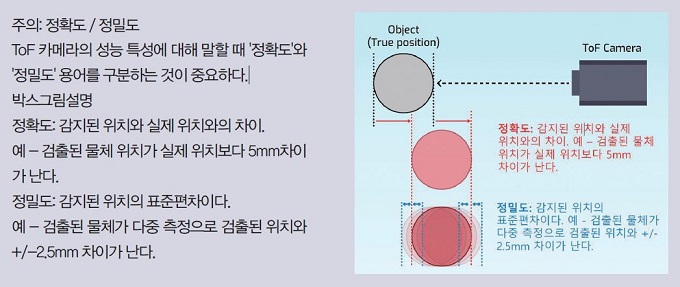

자동 자재 취급 시스템과 같은 애플리케이션은 1-3m의 거리에서 작동하며 약 1-5mm의 정확한 측정을 필요로 한다. 이러한 애플리케이션에서 비행거리측정센서(ToF) 이미징 솔루션은 매우 경쟁력이 있다. 비행거리측정센서(ToF) 시스템은 장치에서 방출한 빛이 장면에 담는 물체에서 반사되어 이미지의 전방지점으로 돌아오는데 걸리는 시간을 측정한다(그림 7). 비행거리측정센서(ToF) 카메라는 펄스 변조 또는 연속파(CW) 변조 중 하나를 사용한다. 직접 비행거리측정센서(Direct ToF)라고도 하는 펄스변조는 짧은 광 펄스를 방출하고 카메라로 다시 돌아오는 데 걸리는 시간을 측정한다(그림 8). 연속파(CW) 변조는 연속적인 신호를 방출하고 대상까지의 거리에 비례하는 방출된 광파와 복귀하는 광파 사이의 위상이동을 계산한다(그림 9).

그림 7. ToF 시스템에는 광원과 센서가 있다.

그림 8. 펄스변조는 빛의 펄스를 내보내고 빛이 돌아오는데 걸리는 시간을 측정한다. 광속을 알고 있기 때문에 시간 지연은 반사면의 거리에 비례한다.

그림 9. 연속파 변조기술은 방출된 파(wave)와 반사된 파사이의 위상-이동을 측정한다. 위상-이동은 반사면의 거리에 비례한다.

이미지포커스