수산업에서 지속가능한 어업·수산 양식을 위해 기존의 초음파나 온도계 등과 더불어 카메라를 통해 ‘보는’ 행위가 적극적으로 이루어지고 있다. 또한 얻은 화상·영상 등의 시각 정보를 해석·이용하는 것은 날마다 변화하는 대상 자원과 해양 환경에 대응하기 위해 없어서는 안 되는 것이다. 여기서는 양식어를 위한 개체 식별 기술, 수하식 가리비 양식업을 위한 3차원 계측 기술, 계측 행위로 구성된 심층학습 데이터 세트 생성 툴에 대해 소개한다.

양식어를 위한 개체 식별 기술

수산 양식에서 활어조 내 양식어의 정확한 마리 수를 파악하고 관리하는 것은 사료량과 생산출하량을 조절하기 위해 매우 중요하다. 그러나 대부분의 양식 대상은 수만 단위로 사육되기 때문에 중량 등에 따라 어림잡아 관리되는 경우가 많다.

농업 분야에서 R. Ishiyama 등은 멜론 표면의 그물 모양 무늬를 각 개체에서 고유한 것으로 가정, 사람의 지문 대조 기법과 적응하는 개체 식별 기법을 제안하고 있다.

필자 등은 참고등어의 체표면 무늬에 주목해 태그 등의 부여 없이 정확한 마리 수 관리 및 건강관리를 위한 개체 식별 시스템을 제안하고 있다. 여기서는 참고등어의 개체 식별 기법에 대해 소개한다.

1. 참고등어의 개체 식별

대상이 되는 참고등어의 체표면 무늬 예를 그림 1에 나타냈다. 참고등어의 무늬는 튜링 패턴으로 알려져 있으며, 개체 식별에 대해 충분한 패턴이 존재한다고 가정할 수 있다. 이 글에서는 참고등어의 체표 무늬에 주목해 지문 대조에서 이용되는 방법을 이용해 대조한다.

참고등어의 체표 무늬에서 개체 식별을 하기 위해 각 개체의 특징량을 추출한다. 먼저 2치화․세선화하고, 무늬 정보를 취득한다(그림 1 (c)). 취득한 화상으로부터 사람의 지문 대조에서 취급되는 선의 분기점을 추출해 특징점으로 한다. 그림 1 (d)와 같이 참고등어의 체표 무늬 분기점을 특징점으로 검출하고 있다는 것을 알 수 있다.

이 글에서는 우연 일치 확률법을 이용해 대조를 한다. 이것은 등록 화상과 대조 화상의 대응 관계보다 비슷한 대응 관계를 우연히 얻을 수 있는 확률을 평가 기준으로 하는 기법이다. 이 때문에 특징점의 수에 편차가 있는 경우에도 안정적으로 대조를 할 수 있다. 유사도를 구하는 지표로는 등록 화상과 대조 화상을 겹쳤을 때에 얻을 수 있는 특징점을 바탕으로 한 오수리(誤受理) 확률을 이용한다.

2. 실험

일본 오이타현의 양식연구시설에서 사육되고 있는 참고등어를 대상으로 2019년 10월 31일과 2020년 6월 26일에 촬영된 동영상을 이용했다. 카메라는 GoPro7, 해상도는 2704×1520pixel이다. 촬영은 활어조(지름 1.95m, 수심 0.58m)에 참고등어를 넣고 물속에서 카메라가 연직으로 아래 방향을 향하도록 설치해 실시했다. 10월은 24개체, 6월은 18개체(이 중 1개체는 10월과 동일한 개체), 총 41개체의 참고등어를 이용했다. 개체 식별에는 체표 무늬에 왜곡이 없는 화상으로부터 등록 화상과 대조 화상을 작성해 대조의 정도를 검증한다.

실험에서는 대조 화상으로서 동화상에서 총 100장(No.1~No.100)의 템플릿을 작성해 실험에 이용했다. 단, 대조 화상에는 동일 개체로 방향이나 자세가 다른 것도 포함된다. 대조는 등록 화상 1장과 대조 화상 100장으로 실시해, 합계 100×100가지의 대조를 실시했다. 또한 식별된 결과 화상을 육안으로 확인해 유사도와 비교했다.

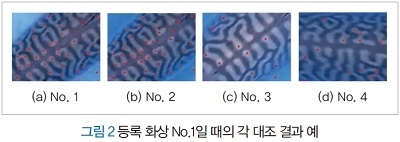

그림 1 (a)의 개체를 등록 화상으로 했을 때의 각 대조 화상과 대조한 결과 예를 그림 2에 나타냈다. 단, No.2(그림 2 (b))는 No.1과 동일 개체로 동일 자세, No.3과 No.4(그림 2 (c), (d))는 다른 개체이다. 각 유사도 S의 값은 No.1이 S=61.5, No.2가 S=19.6, No.3이 S=2.5, No.4가 S=0.9를 얻었다.

각 유사도 S의 값을 비교하면 S는 큰 값을 얻을수록 높은 유사성을 나타내므로 동일 개체와 다른 개체를 식별하는 지표로서 반영되고 있다는 것을 알 수 있다. 또한 다른 등록 화상으로 바꾸어 대조를 실시했을 때도 같은 결과를 얻었다. 이 결과로부터 참고등어의 체표 무늬를 이용한 개체 식별은 가능하다는 것이 시사됐다.

바닷속의 3차원 계측 기술

일본 홋카이도의 가리비 어업은 2020년도 어획량이 약 502억 엔인 기간 어업 중 하나이다. 가리비 어업 중 어린 조개를 로프에 매단 수하연을 이용하는 방식을 수하식 양식이라고 한다. 이 방식에서는 수하연을 바닷속에 고정하고 양식하기 때문에 가리비 성장 상황을 파악하기 어렵다.

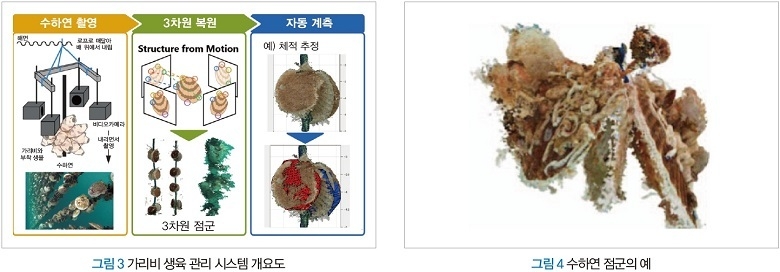

이하에서는 바닷속 수하연을 다방향에서 디지털카메라로 촬영해 3차원 형상(이하 ‘수하연 점군’)을 재구성하고, 가리비의 생육 상황 관측 시스템에 대해 소개한다.

1. 가리비의 생육 상황 관측 시스템

제안 시스템의 개요를 그림 3에 나타냈다. 먼저 수하연을 여러 대의 카메라로 촬영하고, Structure from Motion(SfM)에 의해 3차원 재구성해 수하연 점군을 얻는다. 다음으로 가리비 한쪽 껍데기의 모델 점군을 이용해 자동으로 검출해 가리비와 그것에 부착하는 생물의 체적을 추정한다. 그림 4에 수하연 점군을 나타냈다. 그림 4에서 왼쪽 측의 조개는 열려 있고, 오른쪽 측은 닫혀 있다.

제안 시스템에서는 가리비의 자동 계측을 위해 수하연 점군 중의 가리비 부분을 추출할 필요가 있다. 수하연 점군은 이하의 두 가지 특징을 가진다. 하나는 가리비 표면에 존재하는 부착 생물에 의한 조개 표면 영역의 손상, 또 다른 하나는 수중 환경에서 촬영한 화상의 SFM에 의한 재구성에 기인하는 조개 표면 형상의 노이즈이다. 가리비 검출에는 복수의 3차원 형상 간의 위치맞춤 기법으로 알려져 있으며, Iterative Closest Point(ICP)의 파생형인 Sparse ICP를 이용한다. ICP는 두 개의 3차원 형상을 모델 점군과 데이터 점군으로 할 때, 모델 점군을 움직여 데이터 점군과의 차이를 최소로 하는 회전 행렬과 병진 벡터를 추정한다. Sparse ICP는 ICP의 파생 기법으로, 형상 결손이나 이상값에 로버스트하다.

보통 수하연 점군은 높이 방향으로 긴 로프에 가리비가 일정 간격으로 위치하고 있다. 이 글에서는 간단하게 수하연 점군의 동일한 높이에 위치하는 두 개의 가리비 부분을 잘라낸 1단 분량을 대상으로 한다.

기존 기술에서는 ICP 알고리즘에 의해 검출할 때, 국소해에 빠져 최적해를 얻을 수 없는 초기 위치 의존성이 확인됐다. 따라서 제안 기법에서는 이 문제를 해결하기 위해 복수 초기 위치를 부여하고, 실제 양식 환경에서 취득한 데이터에 대해 검증했다.

제안 기법은 이하와 같다. 먼저 전처리로서 각 점군의 높이 방향이 일치하도록 스케일을 조정하고 다운 샘플링한다. Sparse ICP에서의 각 초기 위치는 데이터 점군의 각 점 좌표의 평균값을 중심으로 하고, 복수의 반경을 갖는 동심원 모양으로 배치한다. 반경은 데이터 점군의 중심 좌표에서 수평 방향의 최대 좌표값으로 0~1로 정규화해 0.2씩 설정된다.

또한 원주 상에 배치하기 위한 이동 각도는 10도씩으로 했다. 이것에 의해 기존 기술에서는 8점의 초기 위치에 대해 제안 기법에서는 504점이 됐다. 각 초기 위치에서 Sparce ICP를 여러 번 실행함으로써 가리비를 한쪽 껍데기씩 검출한다. 각 초기 위치에서의 결과는 위치맞춤된 모델 점군의 각 점과 데이터 점군 중 최근방 점 간 거리의 L2 놈의 제곱에 의해 평가하고, 각 수렴 결과의 위치 관계와 방향을 고려해 조개껍데기 이외의 위치에 수렴한 결과를 제외함으로써 최적의 결과를 선택한다. 또한 이들 초기 위치에서의 Sparse ICP를 실행하기 위한 각 파라미터는 경험적으로 설정했다.

2. 실험

각 점군의 재구성에는 SfM에 의해 3차원 형상을 재구성하는 Agisoft사제 PhotoScan Professional을 이용했다. SFM을 위한 화상의 촬영에는 OLYMPUS사제 디지털카메라 Tough-5를 사용하고, 3차원 형상의 재구성에 성공한 9종류의 데이터를 이용했다.

그림 5에 그림 4의 수하연 점군에 대한 실행 결과 예를 나타냈다. 그림 5에서 왼쪽 측의 열려 있는 조개와 오른쪽 측의 닫혀 있는 조개에 겹치도록 모델 점군이 수렴했다. 실험에 사용한 9종의 데이터 중 6종의 데이터에서 수하연 중의 각 조개껍데기에 수렴하는 검출 결과를 얻을 수 있었다.

제안 기법에서는 ICP의 초기 위치 의존성을 해결하기 위해 여러 초기 위치를 부여해 실제 양식 환경에서 취득한 데이터에 대해 유효성을 보였다. 앞으로는 데이터를 늘려 실험해서 초기 위치 수를 최적화할 예정이다.

계측 행위에 구성된 심층학습 데이터 세트 생성 도구

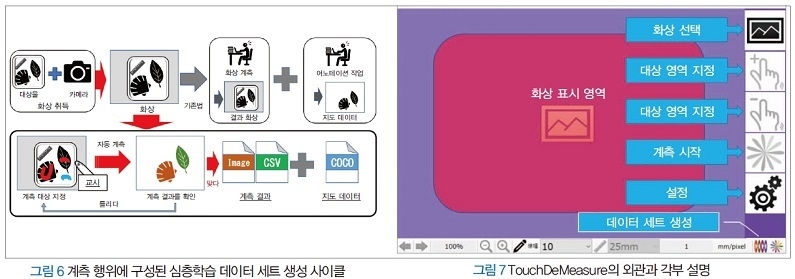

이하에서는 사용자가 화상 계측 지원 툴에 의한 계측 행위에 어노테이션(annotation) 작업을 구성함으로써 통상 작업에 어노테이션 작업을 내포해 완결시키는 심층학습 데이터 세트 생성 사이클에 대해 소개한다.

1. 개요

심층학습의 발전에 의해 대량이며 또한 정확한 지도 데이터 세트의 중요성이 증가하고 있다. 그러나 수산업에서 응용하는 경우, 적합한 데이터 세트가 있는 것은 드물기 때문에 새롭게 어노테이션해 작성할 필요가 있다.

이번 연구에서 제안하는 시스템의 개략을 그림 6에 나타냈다. 기존 기법에서는 화상 취득 후, 화상 계측 작업과 어노테이션 작업을 양쪽 모두 해야 했다. 제안 시스템에서는 화상 계측 결과를 심층학습 데이터 생성을 위한 정보로 활용해 데이터 세트를 생성한다. 그림 6으로부터 화상 계측은 사용자가 대상 화상에 대해 계측 대상의 위치, 종류를 부여하는 행위로, 어노테이션임에 틀림없다.

필자 등은 계측 대상을 포함한 화상에 대해 계측 영역을 ‘덧그리다’라고 하는 터치 교시에 의해 ‘계측하다’를 실현하는 화상 계측 지원 툴 「TouchDeMeasure」를 제안하고 있다. 이 글에서는 TouchDeMeasure에 어노테이션 기능을 실장하고, 실험을 통해 제안 시스템의 유효성을 보인다.

2. 시스템 설계

제안 시스템에서는 화상 계측에 라벨링이 구성되어 있으며, 화상 계측 결과를 심층학습을 위한 데이터 세트로서 이용할 수 있다. 또한 측정 결과는 사용자에 의해 조사 목적의 정도가 보장되기 때문에 정도와 신뢰성이 보증된 화상 계측의 결과를 데이터 세트로서 활용할 수 있게 된다.

기존의 화상 계측에서는 사용자가 계측점이나 대상 영역을 정확하게 클릭·드래그에 의해 지정할 필요가 있어 계측 정도에 영향을 주고 있었다. 제안 시스템에서는 대상 영역 내를 덧그리는 것만으로 화상 계측이 실현된다.

개발 환경은 Windows10, Microsoft Visual Studio C#이며, 동작 환경은 터치스크린 및 마우스 조작에 대응했다. 기본 기능은 기존의 화상 계측에 더해, COCO 형식의 출력에 대응했다. 제안 시스템의 외관과 각부 설명을 그림 7에 나타냈다.

이 글에서는 제안 시스템을 필자 등이 개발한 화상 계측 지원 툴 「TouchDeMeasure」에 실장했다. 제안 시스템의 조작은 다음과 같이 이루어진다. 우선 대상 화상을 선택하고, 필요에 따라 설정 화면에서 계측 모드 등을 지정한다. 다음으로 대상(전경) 영역 및 대상 외(배경) 영역의 안쪽을 터치 교시(드래그 조작)로 지정하고, 계측 버튼을 누르면 자동 계측된다. 제안 시스템에서는 터치 교시를 시드로 한 영역 확장법에 의한 영역 추출 모듈과 얻어진 영역에 대해 계측 대상마다 최적화된 계측 모듈의 조합에 의해 화상 계측 지원이 실현된다. 결과를 확인하고 문제가 있으면 재계측하고, 문제가 없으면 보존 버튼을 눌러 결과를 보존한다. 이때 지도 데이터도 동시에 보존된다.

대상 영역은 제안 시스템의 영역 추출 모듈에 의해 얻어지기 때문에 사용자의 지식이나 경험 등에 관계없는 계측과 어노테이션이 실현된다.

3. 실험

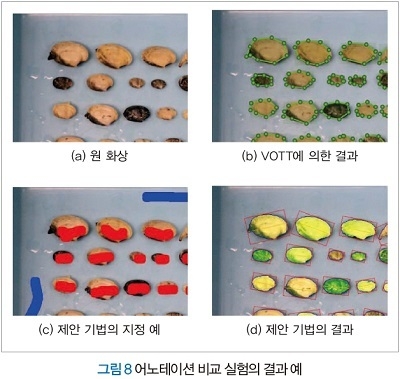

제안하는 어노테이션 툴의 유효성을 나타내기 위해 실험을 했다. 여기서는 제안 기법과 기존 기법의 VOTT를 이용한 어노테이션 작업 시간을 비교한다. 사용한 화상은 바지락의 자원량 조사에 사용되는 사이즈 1152×648pixel, 24bit의 디지털 화상, 1장이다. 대상 화상 내에는 계측 대상이 되는 바지락이 50개체와 자원량 조사를 위한 스케일이 포함된다.

실험 참가자는 21~23세의 남성 3명이다. 이 중에서 실험 참가자 한 명은 어노테이션 작업 경험자이다. 실험 참가자에게는 VoTT에 의한 어노테이션 작업을 지시하고 작업 시간을 측정한다. 다음으로 제안 기법에 의한 어노테이션 작업을 지시하지만, 화상 계측도 동시에 이루어진다. 또한 작업 시간은 작업 시작부터 어노테이션 결과의 확인이 끝나고 데이터를 보존할 때까지의 시간으로 했다.

기존 기법과 제안 기법에 의한 어노테이션 결과의 비교 예를 그림 8에, 어노테이션 작업의 시간 비교 결과를 표 1에 나타냈다. 그림 8 (b)로부터 기존 기법인 VoTT에서는 대상 영역 경계 상에 복수 점을 지정할 필요가 있지만, 제안 기법에서는 대상 영역 내를 터치 교시(그림 8 (c))에 의해 대상 영역을 추출할 수 있으며 폴리곤도 취득된다(그림 8 (d)). 어노테이션 작업의 시간을 비교하면, 표 1과 같이 기존법에서는 1개체당 약 10~19초에 대해 제안 기법에서는 약 2~3초로 작업 시간이 대폭 단축됐다. 또한 제안 기법은 어노테이션 작업과 동시에 화상 계측 작업도 이루어지고 있으며, 어노테이션·화상 계측 모두 경험·지식에 관계없이 안정된 결과를 얻을 수 있었다.